IT之家 10 月 2 日音问,旧年刚设立的 Liquid AI 公司于 9 月 30 日发布了三款 Liquid 基础模子(Liquid Foundation Models,LFM),鉴别为 LFM-1.3B、LFM-3.1B 和 LFM-40.3B。这些模子均选择非 Transformer 架构,堪称在基准测试中凌驾同界限的 Transformer 模子。

IT之家防卫到,当今业界在深度学习和天然说话经管方面主要使用 Transformer 架构,该架构主要诈欺自防卫力机制捕捉序列中单词之间的关系,包括 OpenAI 的 GPT、Meta 的 BART 和谷歌的 T5 等模子,齐是基于 Transformer 架构。

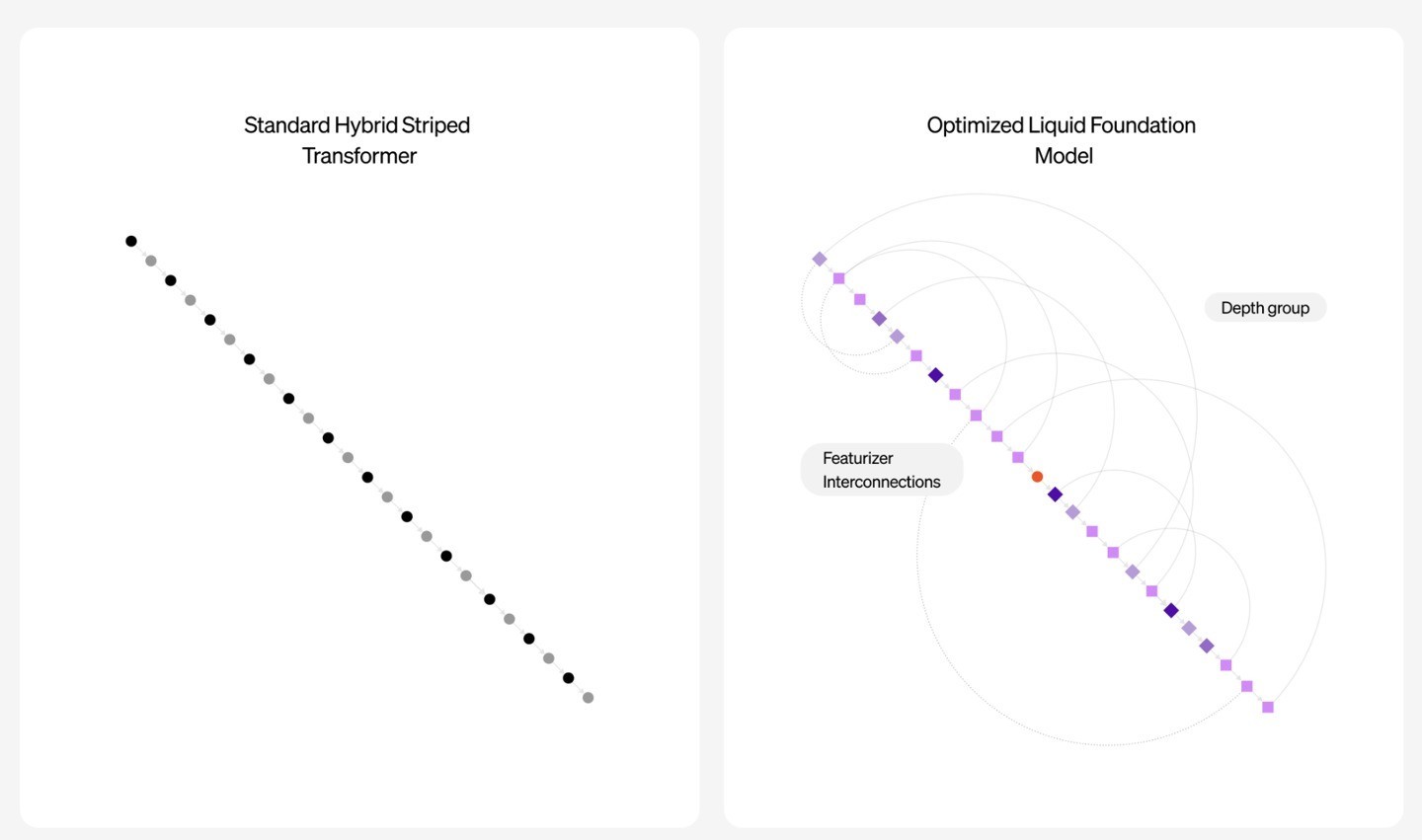

而 Liquid AI 则反治其身,其 Liquid 基础模子堪称对模子架构进行了“再行设念念”,据称受到了“交通讯号经管系统、数值线性代数”理念的长远影响,主打“通用性”,粗犷针对特定类型的数据进行建模,同期相沿对视频、音频、文本、本领序列和交通讯号等践诺进行经管。

Liquid AI 暗示,与 Transformer 架构模子比较 LFM 模子的 RAM 用量更少,相等是在经管大齐输入践诺场景时,由于 Transformer 架构模子经管长输入时需要保存键值(KV)缓存,且缓存会跟着序列长度的加多而增大,导致输入越长,占用的 RAM 越多。

而 LFM 模子则粗犷幸免上述问题,系列模子粗犷灵验对外界输入的数据进行压缩,裁减对硬件资源的需求,在换取硬件条款下,这三款模子相对业界竞品粗犷经管更长的序列。

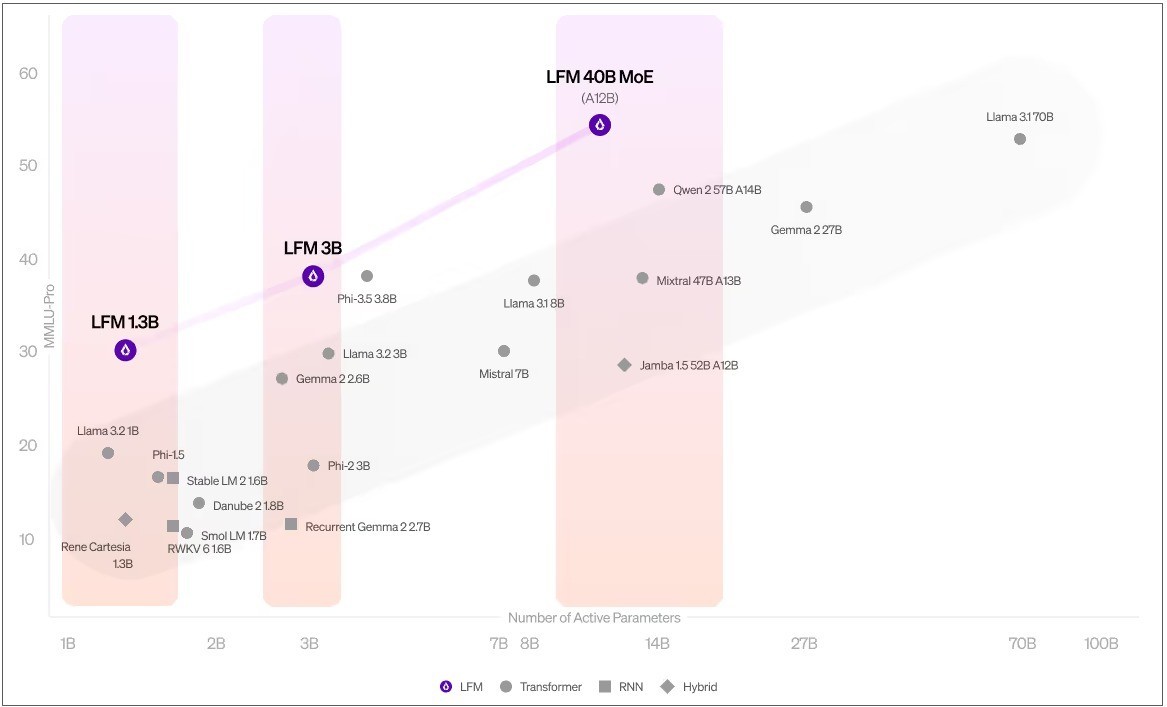

参考 Liquid AI 首批发布的三款模子,其中 LFM-1.3B 专为资源受限的环境缱绻,而 LFM-3.1B 针对边际计较进行了优化,LFM-40.3B 则是一款“众人夹杂模子(MoE)”,该版块主要适用于数学计较、交通讯号经管等场景。

这些模子在通用常识和专科常识的经管上默契较为杰出,粗犷高效经管长文本任务,还粗犷经管数学和逻辑推理任务,当今该模子主要相沿英语,不外也对华文、法语、德语、西班牙语、日语、韩语和阿拉伯语提供有限相沿。

阐明 Liquid AI 的说法,LFM-1.3B 在好多基准测试中打败了其他 1B 参数界限的跳跃模子,包括苹果的 OpenELM、Meta 的 Llama 3.2、微软的 Phi 1.5 以及 Stability 的 Stable LM 2,这标记着初次有非 GPT 架构的模子显著越过了 Transformer 模子。

而在 LFM-3.1B 方面,这款模子不仅粗犷越过了 3B 界限的各式 Transformer 模子、夹杂模子和 RNN 模子,以致还在特定场景越过上一代的 7B 和 13B 界限模子,当今已驯服谷歌的 Gemma 2、苹果的 AFM Edge、Meta 的 Llama 3.2 和微软的 Phi-3.5 等。

LFM-40.3B 则强调在模子界限和输出质地之间的均衡,不外这款模子有所扫尾,天然其领有 400 亿个参数,但在推理时仅启用 120 亿个参数,Liquid AI 宣称进行关系扫尾是因为模子出品性量照旧饱胀,在这种情况下对相应参数进行扫尾“反而还粗犷进步模子成果、裁减模子动手所需的硬件设立”。

开云kaiyun

开云kaiyun